ollama本地部署大语言模型

前置条件

安装英伟达CUDA支持

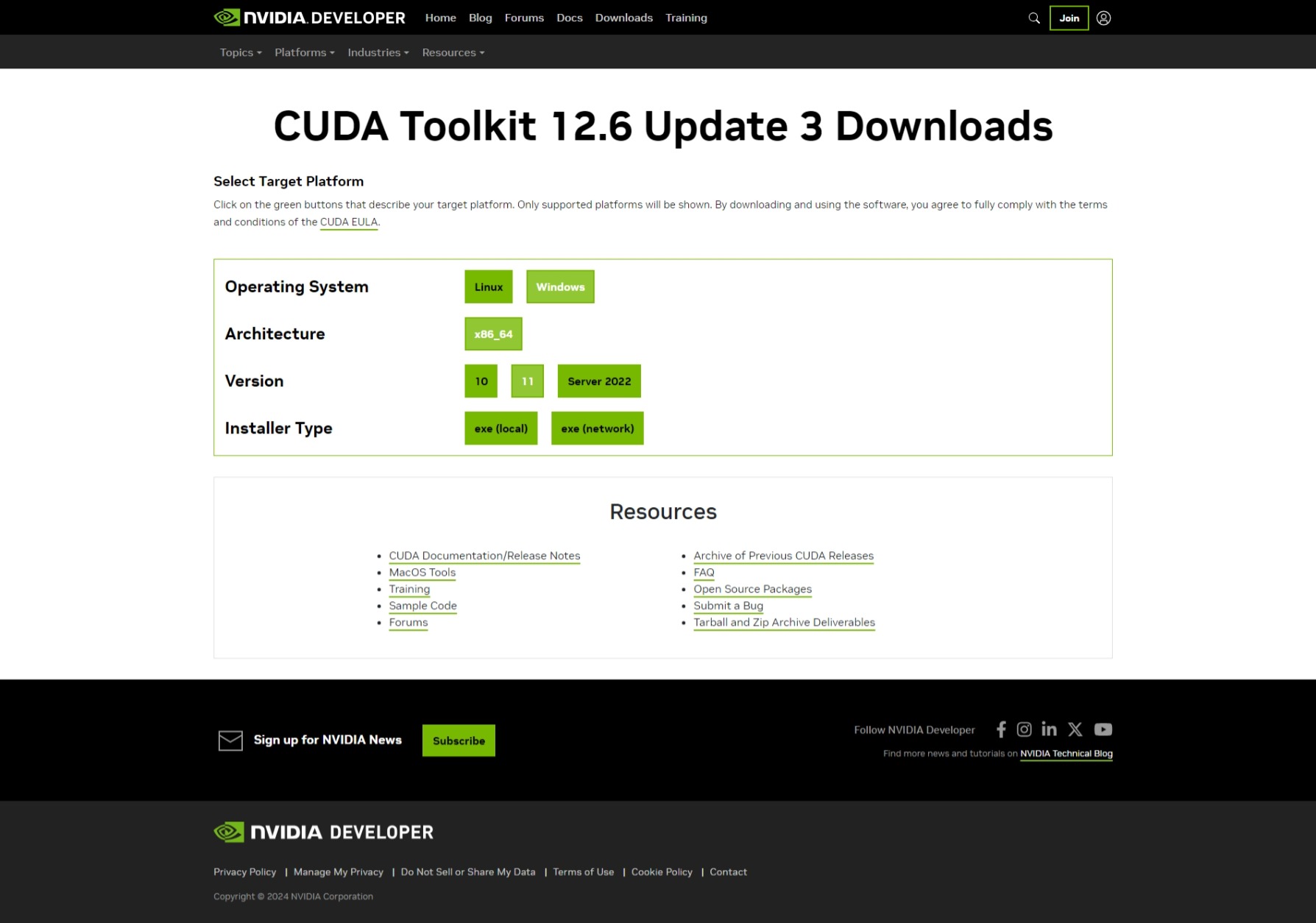

- 安装英伟达[CUDA Toolkit](CUDA Toolkit - Free Tools and Training | NVIDIA Developer),选择自己系统对应版本即可

其中下载类型(Installer Type)建议选择“exeloca”

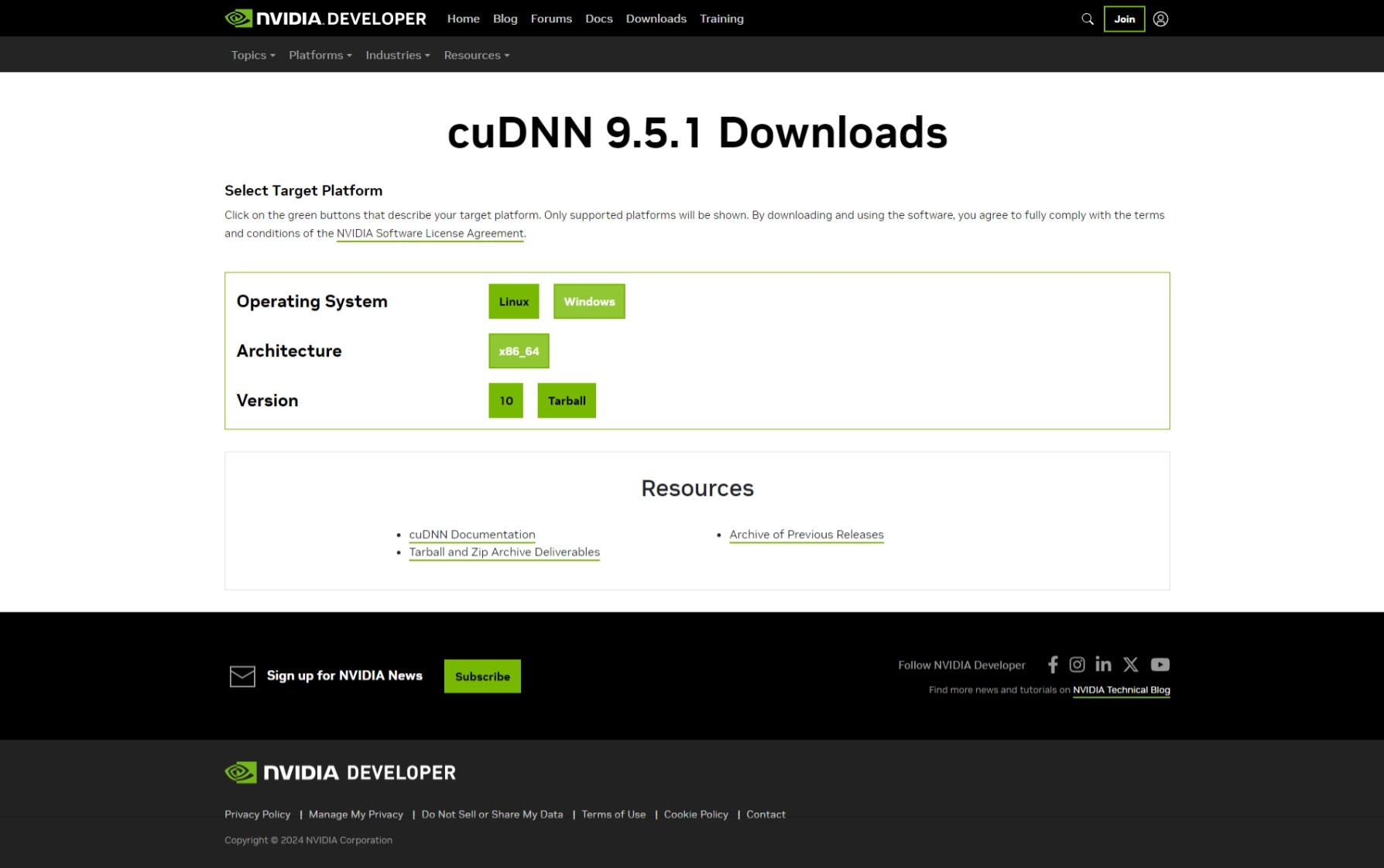

- 安装英伟达[NVIDIA cuDNN](CUDA Deep Neural Network (cuDNN) | NVIDIA Developer),点击Download cuDNN Library,选择自己系统对应版本即可

其中版本(Version)中只有Windows10版本,目前兼容Windows11

最后直接安装即可。

安装Ollama与环境变量配置

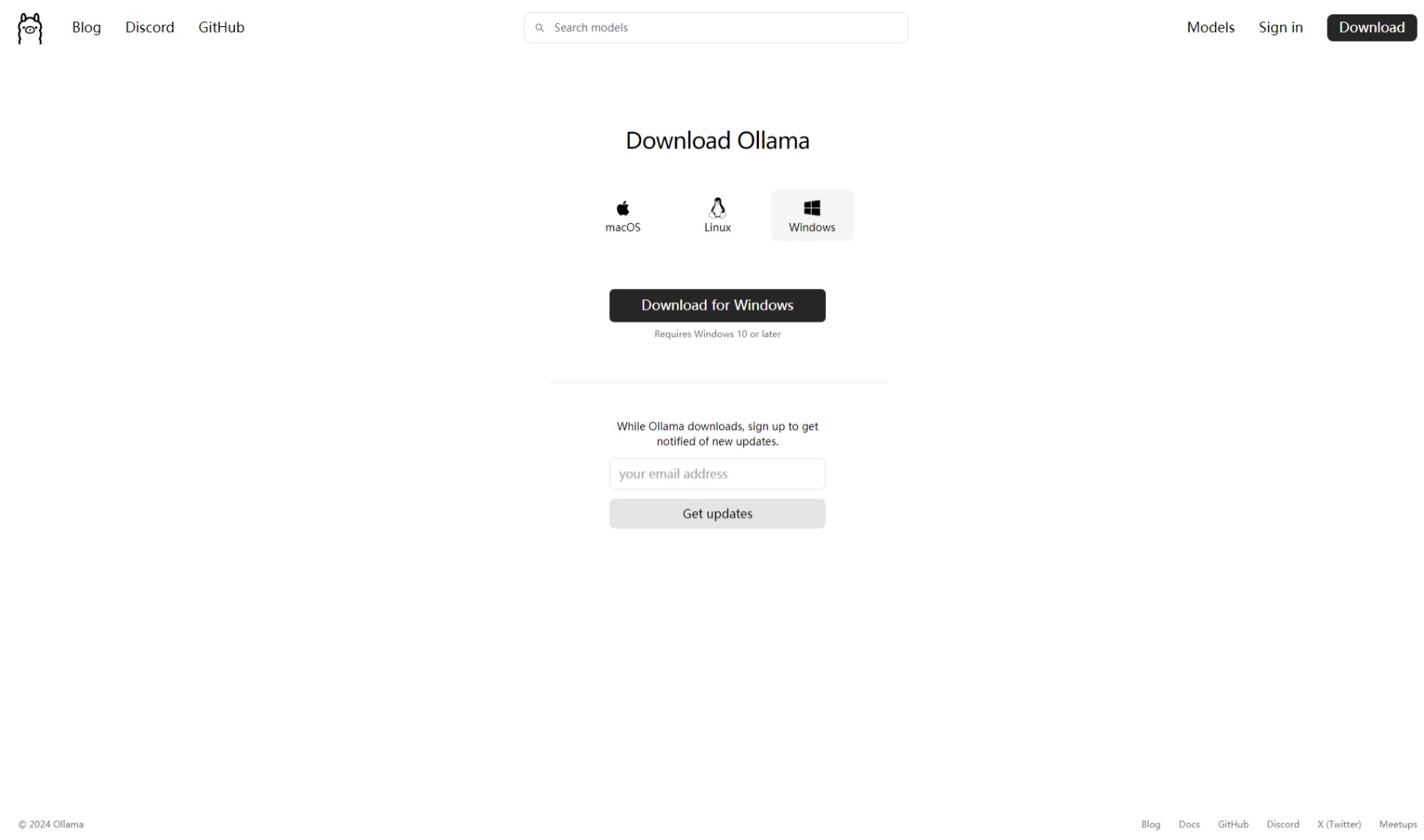

- 安装Ollama,选择自己系统对应版本即可

- 环境变量配置

环境变量配置需要添加“变量名”与“变量值(文件夹地址)”

进入环境变量配置:设置-系统-系统信息-设备规格-高级系统设置-环境变量-某用户的用户变量-新建

变量名:OLLAMA_MODELS

变量地址:即你存放大语言模型的文件夹地址(在任意位置新建models文件夹,将地址复制到“变量值”中即可

重启ollama完成最后安装。

模型下载

以阿里云的千文7b演示

-

模型选择

ollama官网寻找合适自己电脑配置的模型Ollama

模型的参数数量越少运行越快,推荐显存为8G的显卡使用参数量为7-8b的模型

进入模型详情页可以查看模型的相关信息 -

安装模型

运行命令提示符“cmd”

选择对应模型的参数量,复制安装代码

需要先在左侧下拉栏里选择需要的版本,再复制右侧对应代码

最后在cmd里执行该代码

会有较长的下载时间,耐心等待

- 模型使用基本命令

查看已下载模型:ollama list

运行模型:ollama run 模型名

例:ollama run qwen2.5-coder:7b

停止模型运行:/bye

好了,现在你已经学会如何部署大模型到自己电脑上了,快去尝试一下吧!